Mitarbeiter:innen des Moments

Hier stellen wir euch in Form von Cases einige Projekte vor, auf die wir besonders stolz sind.

Mitarbeiter:innen des Moments

Hier stellen wir euch in Form von Cases einige Projekte vor, auf die wir besonders stolz sind.

Die Bereinigung des Google Index ist eine wichtige SEO Aufgabe, deren ordentliche Erledigung positive Auswirkungen auf die Ranking-Positionen hat. Im folgenden Beitrag erfahrt Ihr, welche Aspekte für eine Bereinigung des Index sprechen und wie man dies am effektivsten macht.

Jede Seite eines Webprojekts hat eine URL. Je nach eingesetzter Software (CMS, Onlineshop) können durch eine unüberlegte Programmierung Dubletten einer Seite entstehen, sprich Kopien des vorhandenen Contents. Google verschwendet Rechenleistung und Speicherkapazität um mehrfach vorhandenen Inhalt zu crawlen und zu indexieren. Halten wir Google davon ab mehrfach vorhandene Seiten zu crawlen und zu indexieren wird das unsere Rankingposition verbessern.

404 Fehlermeldungen werden vom Server ausgegeben wenn eine Seite nicht erreichbar ist. Das kann passieren, wenn interne oder externe Links auf nicht vorhandene Inhalte verweisen. Ist das der Fall, gibt der Server die Fehlermeldung „404 – Seite nicht gefunden“ aus. Dies hat einen schlechten Usability Einfluss und ist ein Zeichen für eine nicht ausreichend gepflegte Webseite. Treten zu viele 404 Fehlermeldungen auf, wird das in den Google Webmastertools als Warnung vermerkt.

Wie bereits erwähnt ist es für Google besonders wichtig den Usern ein optimales Sucherlebnis zu bieten und mit eignen Ressourcen ökonomisch umzugehen. Es ist somit nicht empfehlenswert zu viele irrelevante Unterseiten indexieren und crawlen zu lassen, sondern nur die, die dem User einen Nutzen bringen. Das sind Seiten mit einzigartigem und nützlichem Inhalt. Negativbeispiele sind die bereits erwähnten Duplicate Content Seiten, Archivseiten, Kategorie Seiten mit mehreren Folgeseiten (Paginationsseiten), um nur einige zu nennen. Solche Seiten haben meistens den gleichen oder einen sehr ähnlichen Inhalt (Content) wie andere Seiten auch. Sie weisen zudem den gleichen HTML-Titel und die gleiche Meta Description auf. Solche bringen keinen zusätzlichen Nutzen. Sie sollten somit vom Crawlen und Indexieren durch die Suchmaschine ausgeschlossen werden.

Die Beseitigung ungewollter Seiten ist ganz klar eine Fleißaufgabe. Als erstes müssen die Übeltäter identifiziert und bewertet werden.

Die erste Herausforderung liegt in der Sammlung notwendiger Daten. Im Folgenden findet Ihr bewährte Datenquellen die helfen, mögliche Schrottseiten ausfindig zu machen.

Die Google Webmaster Tools sollten für jeden SEO eine der zentralen Anlaufstellen sein, um Informationen über die Webseite zu sammeln. Hier wird auf Duplicate Content, 404 Fehlermeldungen und sonstige HTML Fehler aufmerksam gemacht.

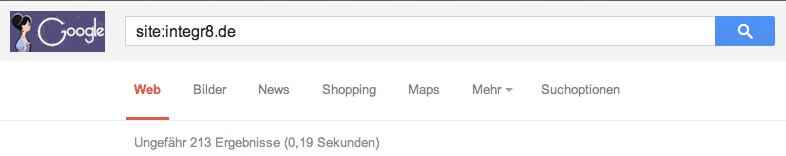

Gibt man in die Suchzeile die folgende Abfrage ein ’site:beispieldomain.tld’ so erhält man eine Auflistung der meisten indexierten Seiten. Hier kann man manuell überprüfen welche Seiten nicht im Index zu finden sein sollten.

SEO Onpage Tools wie z.B. Onpage.org, der Sistrix Optimizer oder Xovi geben ebenfalls wertvolle Informationen über Duplicate oder irrelevanten Content.

Nachdem wir die Datenquellen fokussiert und die Daten gesammelt haben kommt es zu der schwierigsten Aufgabe – die Daten bewerten. Am Anfang des Artikels wurde eruiert welche Arten von Seiten nicht im Index enthalten sein sollten. Im Folgenden werden einige Indikatoren genannt, welche Google Suchergebnisse in diese Kategorien fallen könnten. Die Grundlage bildet die Erwähnte ’SITE:’ Abfrage sowie die oben genannten Datenquellen.

Betrachtet man die Suchergebnisse, so fällt es auf, dass es zu viele gleiche Snippets gibt. Das kann entweder ein Indikator für Duplicate Content (Entfernen) oder eine schlechte Programmierung der Seite sein (Jede Seite sollte neben einem einzigartigen Content einen einzigartigen Snippet haben). Hierzu geben neben der „SITE:“ Abfrage die Onpage-Tools wertvolle Auskunft.

Dynamische URLs können ein Anzeichen für Duplicate Content (DC) sein, da es bei schlecht programmierten CMS mehrere dynamische URLs zum gleichen Inhalt geben kann. Somit solche URLs vermieden und durch suchmaschinenfreundliche URLs ersetzt werden. Neben der DC Problematik werden dynamische URLs von Google schlechter gecrawlt und sehen für den User weniger ansprechend aus.

Neben der „SITE:“ Abfrage sollte man die Daten anderer Quellen zur Bewertung heranziehen. Es gibt keine SEO-Tools die diese Aufgabe für uns vollständig übernehmen können. Die meisten von ihnen liefern sehr wertvolle Indikatoren und Verbesserungsvorschläge. Das blinde Befolgen dieser kann unter Umständen mehr schaden als nutzen – also immer den eigenen Verstand bemühen und bei Unsicherheit uns fragen!

Diese Seiten werden in den Webmaster Tools gemeldet. Weitere Quellen sind die angesprochenen SEO Tools oder Webseiteninterne Plugins die auf die Serverlogs zugreifen.

Wurden die Übeltäter identifiziert, so müssen diese aus dem Index verbannt werden. Hierzu gibt es zwei Methoden. Methode 1– das Setzen eines „No-Index“ Attributs auf der zu entfernenden Seite. Durch diese Methode werden die Seiten durch Google automatisch entfernt. Das kann jedoch einige Zeit dauern. Möchte man die Seiten möglichst schnell aus dem Index entfernen so eignet sich hierfür die Methode 2 – die manuelle Entfernung durch die Webmaster-Tools.

Leider kenne ich keine automatische Maßnahme um diese Schritte in einem Rutsch zu erledigen. Es heißt also viel Geduld aufbringen und jede einzelne URL entfernen. Das kann viel Zeit veranschlagen – aber wozu gibt es Praktikanten

Voraussetzung für die Methode 2

Jede Seite die entfernt werden soll muss entweder:

• eine 404 Fehlermeldung liefern

• durch eine robots.txt gesperrt sein

• oder ein „No Index“ Attribut enthalten

Sollte eine URL in unseren Augen nicht im Index enthalten sein, liefert sie jedoch einen korrekten Statuscode 200, so muss sichergestellt werden, dass diese durch den Google Spider nicht erreichbar ist.

Die Bereinigung des Index und die präventive Vorbeugung vor dem Crawlen unbrauchbarer Seiten schützt Suchmaschinen Ressourcen und sorgt für eine bessere Nutzererfahrung. Google und andere Suchmaschinen werten das positiv, was einen Einfluss auf die Rankings hat. Somit sollte jeder Webmaster dem gute Rankings wichtig sind in regelmäßigen Abständen den Index von Ballast befreien.

Zusammenfassend sollte folgendes getan werden:

• Unbrauchbare Seiten identifizieren

• Setzen eines „No Index“ Attributs (Automatische Entfernung – langsam)

• Manuelle Entfernung über die Webmaster-Tools (Entfernung binnen Stunden)

Starte jetzt dein neues Lieblingsprojekt

Copyright INTEGR8 media GmbH. All Rights Reserved